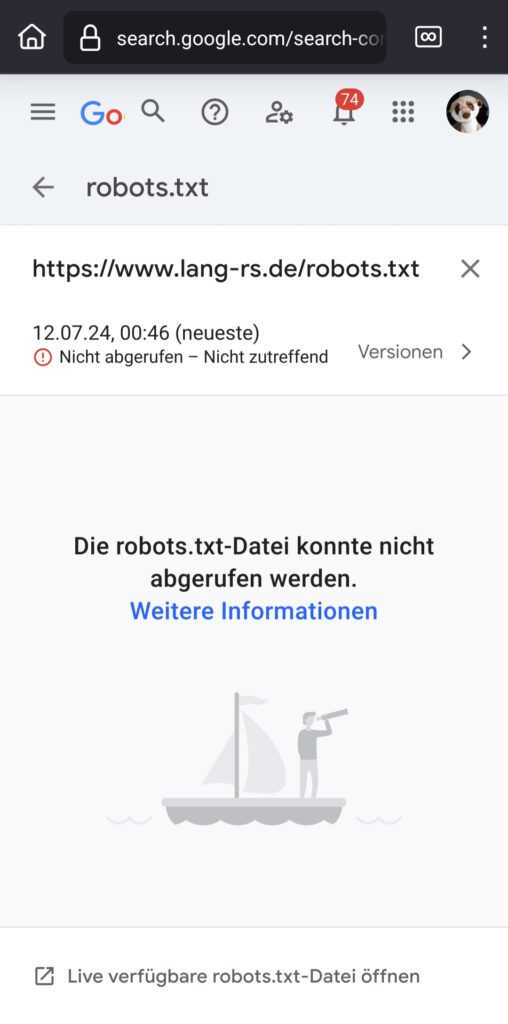

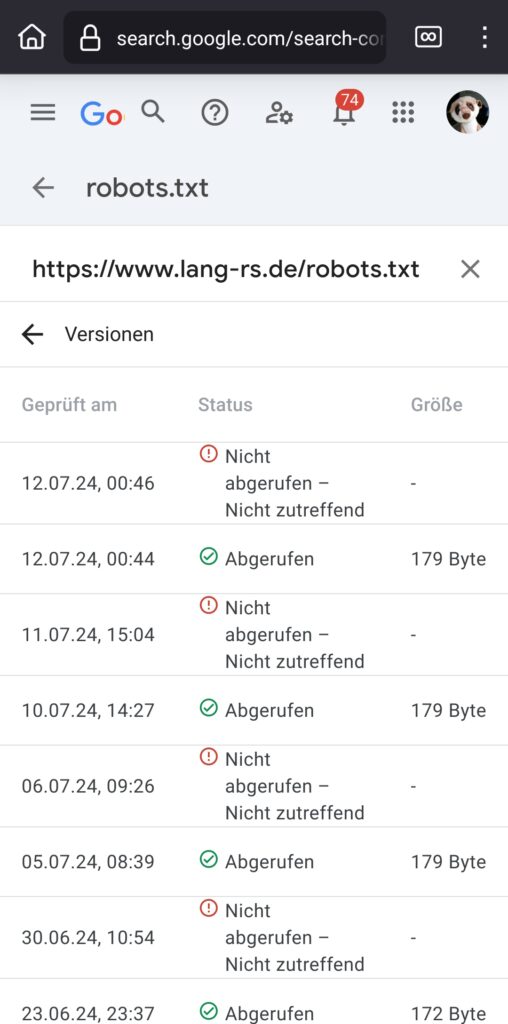

Seit 3 Wochen geht das nun so, die Google Search Console (GCS) meldet einen Fehler: robots.txt unavailable oder nicht erreichbar. Robots.txt kann nicht abgerufen werden, so ein Meldungstext. Obwohl sie Live in der GCS verfügbar ist! Verrückt! Seitdem werden auch die entsprechenden Sitemaps aus sitemap_index.xml nicht mehr abgerufen oder aktualisiert. Ein Crawling, also die Indexierung der neuen Inhalte, findet nicht mehr oder nur noch sporadisch statt.

Für meine private Homepage mit Blog ist das vielleicht etwas ärgerlich, aber mehr auch nicht. Aber wenn jemand einen Onlineshop betreibt, könnte das schnell existenzgefährdend sein. Was kann man dagegen tun? Wie wird die eigene Website wieder indiziert und damit öffentlich präsentiert?

Die Hilfefunktion der Google Search Console bleibt da erstaunlich unpräzise. Ich habe alle Hilfeseiten versucht zu verstehen, bin aber letztlich nicht weiter gekommen. Die Suchergebnisse im Netz sind ebenfalls ungenau, ja bisweilen unprofessionell. Warum kann die initiale Meldung der GCS nicht einen Lösungsweg zeigen? Warum wird kein Fehlercode genannt? Ich empfinde Ohnmacht. Die robots.txt ist im Root-Verzeichnis vorhanden, sie lässt sich im Browser anzeigen, auch hat sie den korrekten Inhalt, also keine DISALLOW-Anweisungen. Alle Website-Checker im Netz können keinen Fehler erkennen. Dennoch will die GCS robots.txt nicht lesen.

Auch der Support des WordPress Plugins Yoast SEO findet keine Fehler. Allerdings wird auf den Webhoster verwiesen. Vielleicht ein Serverfehler, oder eine Blockade durch die Firewall?

Anschließend habe ich meinen Webhoster 1blu angeschrieben. Nach Hin und Her und mehreren Screenshots der GCS mit dem Hoststatus war es so weit: Der Webhoster reinitialisierte die Firewall, und das Problem war weg. Nach drei Arbeitstagen. OK, es handelt sich um ein preiswertes Homepage-Paket. Gut, dass ich meine WordPress-Installation nicht angerührt habe. Wer weiß, was dann noch geschehen wäre.

Fehler gelöst: robots.txt unavailable oder nicht erreichbar. Es lag hier an der Firewall beim Webhoster. Letzlich war die Lösung also gar nicht so schwierig. Erstaunlich, dass das Problem mit der Firewall im Netz nicht öfter Erwähnung findet.